Réplica à nota técnica de Pedro Valls e Emerson Marçal (estudo sobre a PEC 45/2019)

Os professores da EESP/FGV, Pedro Valls e Emerson Marçal, divulgaram recentemente uma nota técnica[1] questionando vários aspectos da metodologia que empreguei para preparar um estudo para o Centro de Cidadania Fiscal (CCiF), o qual buscou quantificar os impactos macroeconômicos de uma eventual aprovação da PEC 45/2019. A conclusão deles é que meu estudo é “(...) limitado, inicial e bastante frágil para se fazer prescrição de política econômica”.

Antes de prosseguir, vale assinalar que esta não foi a primeira crítica que recebi: José Roberto Afonso, Vagner Ardeo e Geraldo Biasotto Jr. também divulgaram um texto questionando minha metodologia e meus resultados. Aqui minha resposta à crítica deles. Há pouca sobreposição entre as críticas de Valls & Marçal e aquelas de Afonso, Ardeo e Biasotto, convém notar.

Voltando à crítica mais recente, de fato meu estudo é “inicial”. Embora a reforma da tributação indireta nos moldes daquela consubstanciada na PEC 45/2019 esteja em debate público pelo menos desde 2017 – sendo fortemente recomendada pela OCDE e por especialistas como a profa. Rita de La Feria, dentre outros -, meu estudo, divulgado em meados de 2020, foi um dos primeiros a tentar quantificar alguns dos impactos agregados e de equilíbrio geral de tal reforma.

É interessante notar que a PEC 45/2019 parece estar bem próxima de ser votada no Congresso e basicamente todas as críticas feitas a essa reforma e aos estudos preparados para estimar seus efeitos não vieram acompanhadas de propostas alternativas concretas e/ou estudos alternativos de impactos agregados, limitando-se a questionar os dados, as metodologias e a apontar impactos negativos estáticos e de equilíbrio parcial para alguns poucos estados/municípios e setores “perdedores” (entre aspas, já que uma das narrativas antirreforma insiste no argumento equivocado do jogo de soma zero).

Também é digno de nota a constatação de que várias outras reformas econômicas aprovadas no Brasil nos últimos anos, como a reforma trabalhista (2017), o Cadastro Positivo “2.0” (2018) e a Lei da Liberdade Econômica (2019), dentre outras, não foram amparadas nem mesmo por estudos “iniciais” detalhados e públicos simulando seus impactos prospectivos quantitativos ao longo do tempo sobre a economia brasileira (embora tenham se baseado em experiências de outros países que implementaram reformas semelhantes). Ao menos no caso da PEC 45/2019 temos o meu estudo e alguns outros, como detalharei mais ao final deste texto.

No mais, o estudo que preparei certamente é “limitado”, como deixo evidente na nota técnica, pois estimo apenas alguns dos efeitos macroeconômicos, não avaliando impactos setoriais/regionais, bem como outros aspectos redistributivos relevantes que também podem afetar o bem-estar agregado (os quais foram avaliados por outros estudos, os quais também apontaram impactos favoráveis associadas a essa reforma).

De todo modo, ao simular a reforma no âmbito de um modelo semiestrutural com vários blocos interagindo entre si, inclusive financeiros, eu consegui estimar também os efeitos macroeconômicos indiretos (spillovers) dessa reforma – algo que nem todos os estudos sobre impactos de reformas costumam avaliar explicitamente (em vários deles os efeitos diretos e indiretos são indissociáveis e, em outros, a estimativa se refere apenas ao efeito direto, ignorando alguns aspectos não desprezíveis de equilíbrio geral).

Sobre a “fragilidade”, vou ter que explorar mais detalhadamente alguns dos pontos levantados por Valls & Marçal. Para tanto, vou ter que fazer uma breve introdução sobre os trabalhos que buscam aquilatar os efeitos de reformas/mudanças nas regras do jogo.

Há uma ampla literatura sobre a mensuração de impactos de reformas. Grosso modo, ela se divide em dois grandes grupos: os trabalhos empíricos e aqueles baseados em modelos calibrados.

No caso dos primeiros, o principal objetivo é o de estimar os efeitos macroeconômicos de reformas a partir de “choques reformistas” pretéritos (aqui e aqui dois exemplos de trabalhos, um do BCE e outro do FMI). Esses trabalhos claramente olham para trás, buscando trazer alguns insights sobre os efeitos de futuras reformas, de modo a orientar os policymakers e a própria sociedade sobre prioridades, sequenciamento, efeitos colaterais etc. Importante notar que a identificação dos episódios reformistas na maioria das vezes não é realizada de forma model-based, e sim por um critério que envolve buscar mudanças “relevantes/grandes” de variáveis institucionais/microeconômicas (geralmente mais agregadas), procedimento algumas vezes substituído ou complementado por uma abordagem narrativa.

Já no caso do segundo conjunto de trabalhos, são simulados os efeitos prospectivos de reformas, geralmente pela utilização de modelos “calibrados” e microfundamentados, estáticos (CGE) ou dinâmicos (CGE dinâmico e DSGE). Nesse arcabouço, os efeitos das reformas são simulados a partir de mudanças ad hoc de alguns dos deep parameters, os quais estão associados a tecnologia, preferências e tributação, dentre outros aspectos (aqui um exemplo de trabalho nessa linha, um estudo da OCDE). Embora esses exercícios sejam mais forward-looking e mais imunes à chamada crítica de Lucas, é importante assinalar, dentre outras limitações, que muitas vezes os valores calibrados para vários dos deep parameters nesses modelos são semelhantes aos norte-americanos, por conta da indisponibilidade de dados para outros países.

No caso de meu trabalho, eu busquei combinar um pouco de ambas as abordagens descritas acima, como explicarei a seguir. O ponto de partida é um modelo semiestrutural para a economia brasileira, tipo de arcabouço muito utilizado por Bancos Centrais mundo afora para construir seus cenários macroeconômicos no horizonte relevante para a política monetária (quase 60% dos 30 principais BCs do mundo utilizam tais modelos como seus principais modelos, segundo o Economics Benchmarks 2020 conduzindo pelo Central Banking). Basicamente, tais modelos combinam a estimação de formas reduzidas para algumas variáveis como hiato do produto, inflação, inclinação da estrutura a termo, dentre outras, além de algumas regras de política monetária.

Contudo, na tradição dos BCs, esse modelos quase sempre são de pequeno porte, com poucas equações, e o bloco ligado à evolução da capacidade da oferta (PIB potencial e seus componentes) tipicamente é exógeno, “ortogonal” ao cenário macro de curto e médio prazos (o que significa dizer, dentre outras coisas, que a histerese econômica é inexistente – algo que é imposto e não testado nesses modelos, e que vem sendo desafiado cada vez mais pela evidência empírica, como explorei em mais detalhe aqui).

Eu estendi esse modelo semiestrutural básico/padrão de política monetária acrescentando vários blocos adicionais (modelos para risco-país, câmbio, dívida pública, dentre outros) e equações adicionais para os determinantes “contábeis” (proximate) do PIB potencial, sob a ótica do modelo de crescimento neoclássico (Produtividade Total dos Fatores, estoque de capital e oferta de mão-de-obra). A incorporação desses blocos acrescenta diversos efeitos de equilíbrio geral que não estão presentes nos modelos utilizados pelos BCs, além de permitir construir cenários para bem além do horizonte relevante típico da política monetária (até 3 anos à frente).

Tais variáveis foram endogeneizadas no sistema por meio da estimação de modelos em equação única (cointegração) – como é feito regularmente nesses modelos semiestruturais, embora em alguns casos a estimação seja feita de forma conjunta, via filtro de Kalman -, levando em conta boa parte das variáveis amplamente identificadas pela literatura empírica como sendo determinantes “causais” (ultimate) desses componentes do PIB potencial (aqui um trabalho recente do Banco Mundial apontando tais variáveis, a partir de uma análise estatística levando em conta mais 100 países ao longo de 35 anos).

Como está apontado na nota técnica que preparei, os modelos sempre foram estimados levando em conta defasagens dessas variáveis explicativas, uma espécie de instrumentalização (é bastante comum instrumentalizar variáveis com suas próprias defasagens em modelos de séries de tempo), de modo a minimizar os problemas de endogeneidade e garantir algum grau de causalidade (ao menos em termos de antecedência temporal, no sentido de Granger).

Obviamente, isso, isoladamente, ainda não é suficiente para assegurar boas propriedades estatísticas para tais modelos. Com efeito, eles sempre foram testados em termos das propriedades dos resíduos, estabilidade dos parâmetros estimados e da capacidade de previsão dentro e fora da amostra.

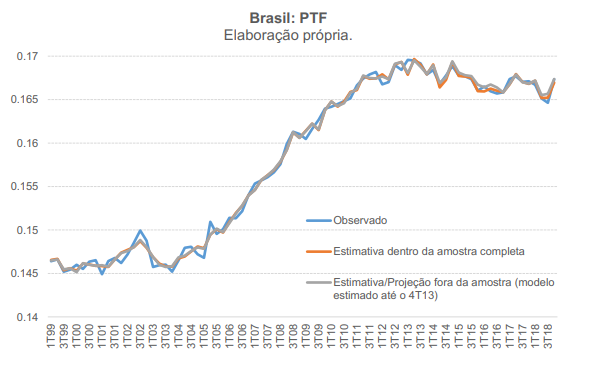

Valls & Marçal apontaram que eu não teria realizado testes de previsão fora da amostra, mas tais testes são apresentados no Apêndice para ao menos 4 variáveis endógenas do sistema, justamente aquelas que são as mais relevantes para se avaliar os efeitos diretos e indiretos da PEC 45/2019 sobre o potencial de crescimento (PTF, em que o modelo é estimado até o final de 2013, com projeções fora da amostra entre 2014 e 2018, como revela a figura abaixo, retirada do apêndice de minha nota técnica; taxa de investimento; hiato do produto e risco-país).

Embora não tenham sido mostrados esses testes para as demais variáveis, eles estão disponíveis sob demanda, já que qualquer modelo semiestrutural utilizado para se realizar previsões, mesmo nas versões mais simplificadas utilizadas pelos BCs, precisa necessariamente ser testado para isso (ainda que boa parte desses testes não sejam apresentados publicamente no caso do BCB, por exemplo: ver aqui e aqui).

No mais, um outro teste crucial – sobretudo no que se refere à avaliação da coerência econômica desse arcabouço em termos da capacidade de simular a reforma da PEC 45 e outras reformas - foi o exercício de convergência condicional dos valores dos parâmetros estruturais/condicionais para aqueles dos EUA (país que está na “fronteira” em termos de produtividade). Em tese, não haveria nada garantindo essa convergência condicional do ponto de vista da modelagem empregada, já que não foi estimado um painel com vários países. Contudo, tal exercício gera como um resultado (e não como uma premissa) uma convergência condicional do PIB per capita e produtividade brasileiros para valores semelhantes àqueles dos EUA, sugerindo que o modelo como um todo apresenta resultados economicamente coerentes. No fundo, esse exercício de convergência condicional é uma espécie de impulso-resposta acumulada multivariada.

Essa é uma constatação pertinente também em outro aspecto: a despeito de eu ter utilizado algumas variáveis não-observáveis para o caso brasileiro, como o PIB potencial e o hiato (que não são públicas; são minhas estimativas), e variáveis construídas por mim a partir de dados públicos (como a dispersão das alíquotas do ICMS origem), no final das contas, no médio e longo prazos, quando o hiato é zero e o PIB efetivo igual ao potencial, o PIB per capita brasileiro convergiria, condicionalmente, para valores próximos do PIB per capita efetivo (observável) norte-americano.

Antes de prosseguir, acho que vale a pena destacar algo colocado por Olivier Blanchard – um dos principais acadêmicos mundiais no campo da macroeconomia teórica e empírica, além de ter sido economista-chefe do FMI por bastante tempo. Em 2016, no âmbito do debate sobre a relevância e os problemas dos modelos DSGE microfundamentados, Blanchard apontou que:

“Different types of general equilibrium models are needed for different purposes. For exploration and pedagogy, the criterion should be transparency and simplicity, and for that, toy models are the right vehicles. For forecasting, the criterion should be forecasting accuracy, and purely statistical models may, for the time being, be best. For conditional forecasting, i.e. to look for example at the effects of changes in policy, more structural models are needed, but they must fit the data closely and do not need to be religious about micro foundations.”

De fato, Estrella & Fuhrer 2003 já haviam demonstrado que, na prática, modelos backward-looking estimados econometricamente (e que não levam em conta explicitamente o comportamento otimizador dos agentes) muitas vezes são mais estáveis do que modelos microfundamentados calibrados.

A utilização de modelos semiestruturais – compostos em boa medida de equações em formas reduzidas - para simular impactos macroeconômicos de reformas não é algo incomum: o FMI utiliza seu “modelão” semiestrutural para a economia global, o G20MOD, para simular não somente os efeitos de choques de política monetária, fiscal e de preços de commodities sobre diversos blocos/países, mas também para simular os efeitos macroeconômicos, de equilíbrio geral, de algumas reformas mais “genéricas” (flexibilizar o mercado de trabalho e aumentar a concorrência no mercado de bens, por exemplo). No caso das “reformas”, elas são introduzidas de forma exógena no G20MOD, por meio de intervenções sobre as trajetórias da produtividade total dos fatores e da oferta de mão de obra, levando em conta os impactos estimados nessas variáveis por meio de outros estudos (o que cria uma limitação para simular os impactos de reformas específicas, mais detalhadas – já que esse procedimento depende da existência de evidência empírica de impactos estimados de reformas pretéritas).

Importante assinalar, ademais, que os documentos publicamente disponíveis sobre o G20MOD apresentam várias de suas equações, bem como algumas funções impulso-reposta, mas sem revelar intervalos de confiança. Também não são apresentados detalhes da estimação das formas reduzidas (capacidade de projeção fora da amostra, testes de exogeneidade e superexogeneidade, dentre outros[2]). Ainda assim, o G20MOD é utilizado para se avaliar efeitos macroeconômicos de reformas.

Voltando ao meu trabalho, os impactos estimados da reforma da PEC 45/2019 levaram em conta os efeitos efetivamente observados no passado brasileiro de mudanças nas variáveis mais estruturais/institucionais sobre alguns desses agregados macroeconômicos, em particular nos componentes “contábeis” do PIB potencial – o que permite recuperar diversas “elasticidades”. Isso aproxima meu trabalho do primeiro tipo de literatura sobre impacto de reformas (“empírica, backward-looking”), mencionado acima.

Tais elasticidades foram combinadas a premissas numéricas para a evolução prospectiva dessas variáveis “reformadas”, obtendo-se, assim, os impactos macroeconômicos estimados da reforma da PEC 45/2019. Isso aproxima meu trabalho do segundo tipo (“simulação, forward-looking”).

Como se trata de um sistema de equações, com aspectos de equilíbrio geral e defasagens distintas em cada equação, na prática os impactos dependem de várias inter-relações entre as variáveis ao longo do tempo - o que torna mais complexo o cálculo dos desvios-padrão dos impactos estimados em meu trabalho (uma crítica pertinente de Valls & Marçal). Vou gerá-los numericamente e publicarei em breve os resultados. De todo modo, é importante adiantar que um aumento de 20% do PIB no nível ao final de 15 anos (sem os efeitos de segunda ordem), como estimei, é um número que dificilmente será igual a zero estatisticamente falando, até mesmo porque todo o processo de estimação das equações do sistema buscou sempre o menor erro de medida possível nas projeções fora da amostra.

Isso me leva a um outro questionamento feito por Valls & Marçal: o fato de que a reforma proposta pela PEC 45/2019 foi simulada, em meu trabalho, a partir de alterações ad hoc em algumas das variáveis exógenas do sistema (e não por mudanças model-based em tais variáveis).

Essa é uma prática comum. Por exemplo, o Banco Mundial, usando seu Long-Term Growth Model (LGTM), faz exatamente esse tipo de exercício para simular trajetórias prospectivas para a PTF para diversos países (ver seção 5 deste background paper). Vale notar que o Banco Mundial disponibiliza publicamente um simulador em Excel do LGTM (aqui).

De todo modo, isso de fato corresponde a uma limitação de meu trabalho – já que outros tipos de reforma também poderiam gerar alterações numéricas semelhantes nas 4 variáveis sensibilizadas em meu exercício. O mapeamento da reforma da PEC 45/2019 nessas variáveis acabou sendo feito por meio da utilização do julgamento de especialistas: eu e Bernard Appy. Como não há outras “PECs 45/2019” efetivamente aprovadas/implementadas no histórico da economia brasileira e mundial, é praticamente impossível simular os efeitos sobre tais variáveis institucionais, de forma model-based, como propõem Valls & Marçal.

Nesse contexto, a definição de premissas numéricas para a evolução das variáveis que tendem a ser sensibilizadas de forma expressiva pela reforma em questão corresponde a uma fragilidade, já que somente algumas delas são fortemente conectadas/mapeadas nas mudanças propostas pelo texto original da PEC 45/2019 (tal como a redução em 5% do preço relativo do investimento por conta da devolução plena dos tributos indiretos incidentes sobre a FBCF brasileira, a redução a zero da dispersão regional das alíquotas do ICMS e o fim dos gastos tributários com tributos federais indiretos, por conta da extinção dos regimes especiais).

No caso da quarta variável sensibilizada em meu exercício, o índice Business Regulations (um dos componentes do Índice de Liberdade Econômica do Fraser Institute), de fato o mapeamento quantitativo/numérico nas mudanças propostas pela PEC 45/2019 é mais difícil (isso vale inclusive para o subcomponente Tax Compliance). Neste caso, optou-se por uma calibragem conservadora das premissas numéricas, com o Brasil convergindo, ao longo de 10 anos, para os valores já observados hoje na média da América Latina (estamos bem abaixo disso, vale notar). E a média latino-americana, por sua vez, está bem abaixo da média global nesse indicador. Como está apontado em meu estudo, a alteração simulada nesta última variável responde por cerca de 36% do impacto direto de 20% sobre o PIB no nível após 15 anos. Ou seja: mesmo ignorando esse impacto, ainda assim o PIB seria cerca de 13% maior.

Por que foi feita essa opção em meu trabalho? Há uma diferença enorme entre estimar o impacto de uma reforma da tributação indireta “genérica” e a proposta específica colocada pela PEC 45/2019.

Embora um trabalho recente do FMI de fato sugira que reformas no mesmo “estilo” daquela colocada pela PEC 45/2019 - mudança do desenho da tributação indireta, na direção de uma base mais ampla e de um menor número de alíquotas e regimes especiais, mantendo inalterado o montante arrecadado - impactam positivamente o crescimento econômico no médio e longo prazo (resultado estimado a partir de modelos econométricos, com uma amostra de cerca de 30 países ao longo de quase 50 anos), ainda assim isso não diz muito a respeito dos efeitos da PEC 45/2019 em si. Até mesmo porque o ponto de partida da economia brasileira em relação a outros países, nesse aspecto, é bastante distinto.

De todo modo, é importante destacar que há outros estudos apontando impactos favoráveis e relevantes sobre a economia brasileira de propostas de reformas nos moldes da PEC 45/2019, a partir de abordagens técnicas bem diferentes daquela que utilizei.

Alguns desses estudos são mais antigos, mas simularam reformas muitos semelhantes àquela colocada pela PEC 45/2019. Um paper do FMI de 2005 elaborado por Victor Lledo estimou, por meio de um modelo CGE dinâmico, que a substituição de PIS, Cofins, IOF e CPMF por um IVA Federal de alíquota única e base ampla elevaria o PIB brasileiro em 9% no longo prazo (ou seja, ele ignorou os impactos do fim da guerra fiscal, dentre outras diferenças em relação ao estudo que preparei). Pereira & Ferreira 2010, por meio de um modelo recursivo dinâmico, estimaram que a criação de um IVA Federal, uma desoneração total dos investimentos e uma desoneração parcial da folha salarial (não neutra, com redução da carga total), elevaria o PIB brasileiro em 14% a 17% no longo prazo (neste caso, eles agregam uma reforma adicional no “pacote”, a desoneração da folha – que explica cerca de 2 p.p. do impacto sobre o PIB na estimativa deles -, mas ignoram, por outro lado, os impactos decorrentes do fim da guerra fiscal, bem como da redução dos custos de conformidade tributária).

Mais recentemente, Oliveira 2020, usando um modelo CGE dinâmico com aberturas setoriais e regionais (para cada um dos estados brasileiros, mais o DF), apontou um ganho de 5,3% de PIB para o Brasil no longo prazo com a introdução de um IVA Nacional, englobando PIS, Cofins, IPI, ICMS e ISS e com alíquota única de 25% (ver aqui um post meu no Observatório de Política Fiscal do IBRE em que mostro que essa estimativa de ganho de PIB de Oliveira não é incompatível com minha, uma vez que ele considera apenas parte dos efeitos que eu levei em conta em meu estudo). Domingues & Freire 2020, utilizando um modelo CGE para a economia brasileira com aberturas setoriais bastante desagregadas, estimam ganhos de PIB para o Brasil decorrentes da implementação da PEC 45/2019 de pelo menos 4% no médio prazo (valor que reflete apenas o efeito da eliminação da cumulatividade e da adoção de uma alíquota uniforme para o consumo de bens e serviços, deixando de considerar a maior parte dos efeitos sobre a produtividade decorrentes da redução dos custos de conformidade).

Por fim, mesmo questionando meu estudo, Marçal parece ser um defensor das propostas de reforma da tributação indireta, ao ter declarado, em reportagem do UOL de setembro deste ano:

“As propostas de reforma tributária que tramitam no Congresso apresentam um retorno maior em termos de crescimento e potencial de melhoria das finanças públicas. Desse modo, o ambiente raro favorável à aprovação de uma reforma tributária em ambas as Casas deveria ser aproveitado”.

Como ainda não há ainda nenhuma proposta concreta de reforma em outros campos da tributação (renda, patrimônio etc.) em tramitação no Congresso, pressupõe-se que Marçal tenha se referido às propostas de reforma da tributação indireta (sobre o consumo).

Além de defender esse tipo de reforma, Marçal também sugere, em artigo no Valor de março deste ano assinado em conjunto com Marcelo Muinhos, que seu impacto econômico tende a ser positivo e expressivo:

“O grau de distorção da atividade econômica provocado pelo atual sistema tributário é tão grande que mesmo pequenas alterações podem gerar efeitos significativos”.

Meu trabalho e outros citados apontaram algo nessa linha, mesmo com suas várias limitações. Ou seja: todos esses estudos corroboram a prior de Marçal, semelhante àquela de vários outros analistas e entidades.

As opiniões expressas neste artigo são de responsabilidade exclusiva do autor, não refletindo necessariamente a opinião institucional da FGV.

[1] Não pude deixar de reparar que o texto deles inaugurou a sessão “Notas Técnicas” no CEQEF/EESP-FGV, que não teve nenhuma outra publicação em 2020 e nos anos anteriores.

[2] Valls & Marçal insistem bastante na questão da super-exogeneidade como uma forma de atestar que um modelo estimado econometricamente pode ser utilizado para realizar previsões e para simular mudanças de política, contornando a crítica de Lucas. Contudo, os próprios testes de super-exogeneidade são alvo de questionamento na academia (algo semelhante acontece com os testes de raiz unitária, por exemplo). Psaradakis & Sola 1996 questionam a utilidade dos testes de super-exogeneidade e invariância estrutural para a avaliação da relevância empírica de modelos econométricos estimados com base nos dados observados, já que seu poder é baixo. Favero & Hendry 1992 também questionam a utilidade desses testes, embora eles interpretem os resultados de seus exercícios sobre o poder de tais testes como algo que enfraquece a crítica de Lucas: “(...) for changes of a magnitude that are large enough to be policy relevant, conditional model approximating expectations process do not in practice experience dramatic predictive failure”. Linde 2001 aponta que “The results suggest that the superexogeneity test is not capable of detecting the relevance of the Lucas critique in practice in small samples”. No caso do debate sobre a relevância prática do problema de endogeneidade, Carvalho, Nechio & Tristão 2018 apontam que, embora em teoria a endogeneidade gere o problema de inconsistência na estimação de regras de Taylor via OLS simples (e não via variáveis instrumentais/GMM), na prática isso acaba se revelando um problema pequeno. Dadas as variâncias relativas dos vários choques afetando a economia em relação aos choques de política monetária, “(...) we show that, for realistic sample sizes, the OLS estimator of monetary policy parameters outperforms IV estimators”. Naturalmente, isso vale para o exercício específico deles (que aliás leva em conta um sistema de 3 equações que é um núcleo de um modelo semiestrutural como aquele que utilizei), mas serve para ilustrar que muitas vezes alguns problemas qualitativos vislumbrados pelas teorias estatística e econômica podem acabar tendo implicações quantitativas práticas modestas. É nesse contexto que se insere a colocação feita por Blanchard, citada anteriormente neste trabalho.

Comentários

Deixar Comentário